Недавно мне понадобилось скачать на жёсткий диск целый сайт, чтобы сохранить его для последующего просмотра в оффлайн режиме. Тогда я в который раз убедился, что CLI утилиты Linux – необычайно мощные и гибкие инструменты, с помощью которых можно сделать практически всё! Вот и в моём случае мне помогла небольшая утилита с управлением из терминала Wget, которая уже давным давно установлена в моём Arch Linux, а во многих дистрибутивах установлена «из коробки».

Итак, как с помошью wget полностью скачать сайт? Очень просто

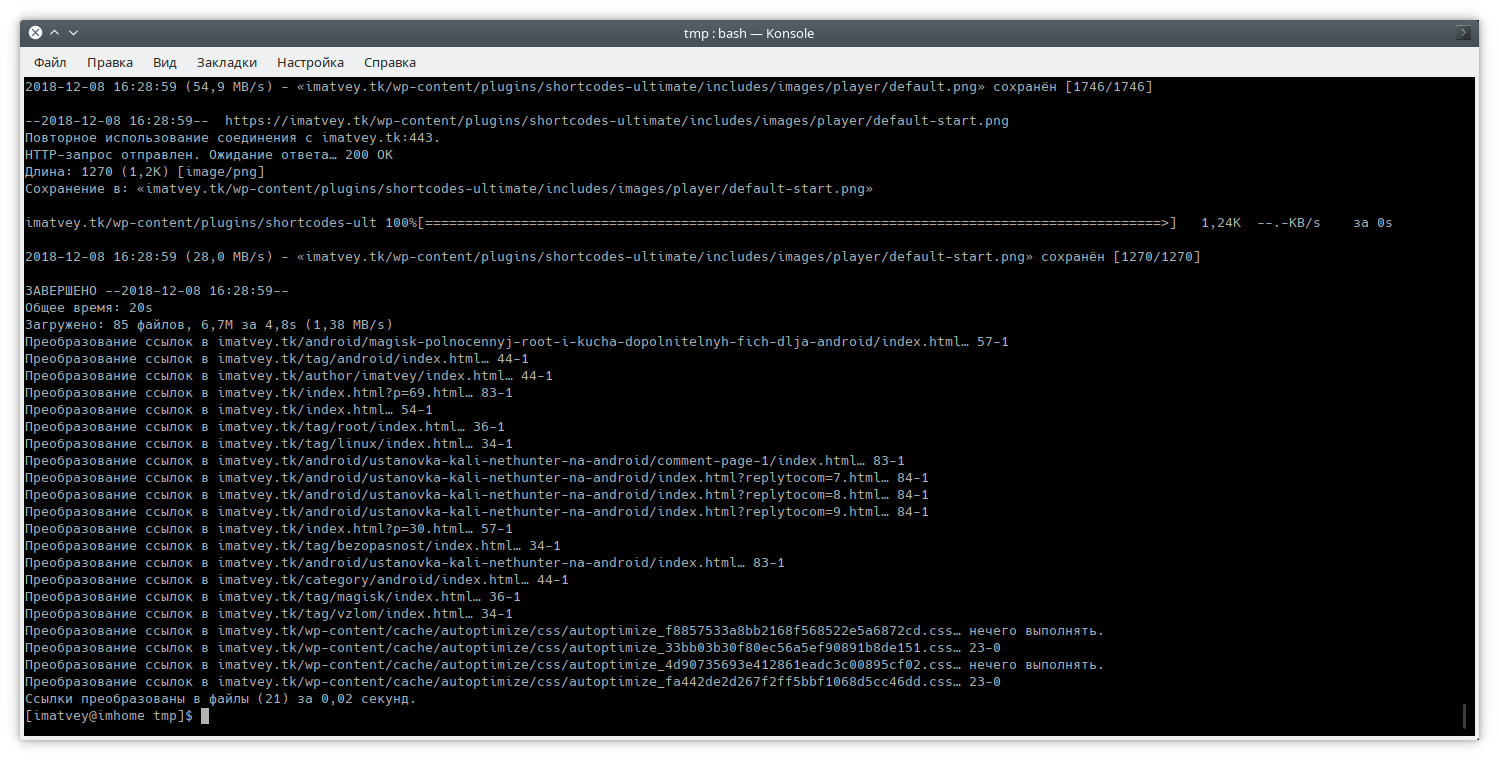

wget -r -k -l 5 -p -E -nc https://imatvey.xyz/Выполнять нужно из той директории, куда нужно скачать сайт. Параметром ‑l можно регулировать глубину вложенности ссылок для обработки. Ну и, естественно, нужно заменить ссылку на мой блог на свою. Как видно, скачать сайт в Linux – проще некуда 😊