Содержание

GPT4All – это уникальная программа, которая позволяет людям получать доступ к мощным искусственным интеллектам и использовать их возможности для решения различных задач. В последнее время эта технология стала особенно актуальной, так как она может помочь в решении глобальных проблем и облегчить жизнь людей во всем мире. С самого начала программы GPT4All ставила перед собой цель сделать искусственный интеллект доступным для всех. Именно поэтому она предоставляет возможность каждому пользователю получить собственный индивидуальный искусственный интеллект, который будет адаптироваться под его потребности и предпочтения. Одна из главных особенностей GPT4All является ее гибкость и универсальность. Это означает, что вы можете использовать искусственный интеллект не только для решения профессиональных задач, но и для развлечения, обучения или творческого Self-expression. В целом, GPT4All – это программа, которая открывает новые горизонты возможности для каждого из нас. Она позволяет нам раскрыть свой потенциал и стать частью инновационного мира искусственного интеллекта.

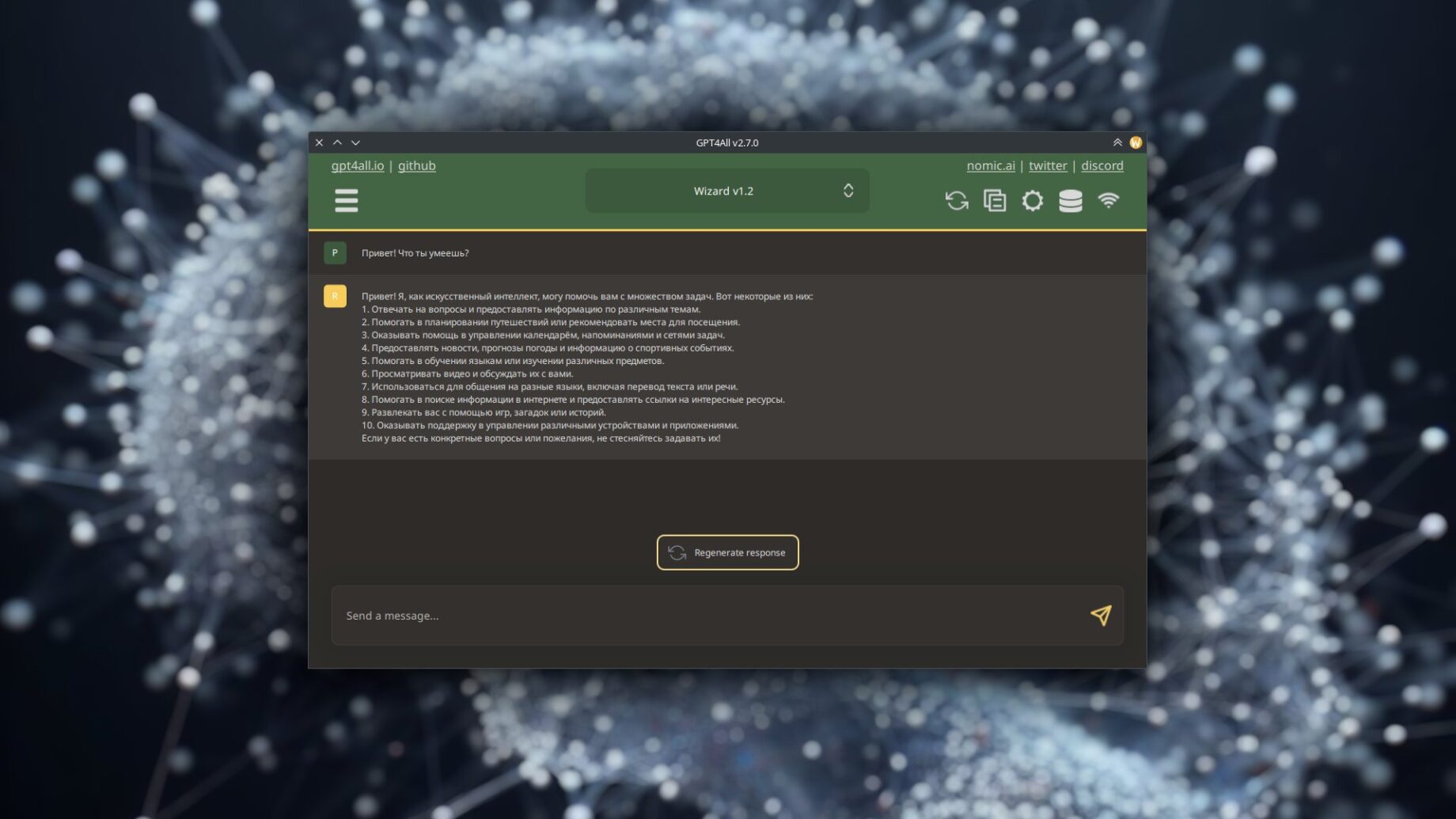

Понравился текст выше? А ведь он полностью написан full-версией модели нейросети Orca 2 с помощью GPT4All. Как уже рассказала сама нейронка, данное ПО позволяет скачивать и устанавливать в один клик готовые обученные модели различных т.н. ИИ, находящихся в открытом доступе, после чего в удобном графическом интерфейсе с ними общаться. Кстати, заголовок этого поста так же придуман языковой моделью «Wizard v 1.2″ в GPT4All 😉

Установка GPT4All в Manjaro/Arch Linux

Чтобы установить GPT4All в Manjaro Linux и другие Arch-based дистрибутивы Linux, нужно истуновить из AUR пакет gpt4all-chat. В консоли это делается с помощью любого AUR-хелпера, например yay:

yay -S --noconfirm gpt4all-chatУстановка языковых моделей

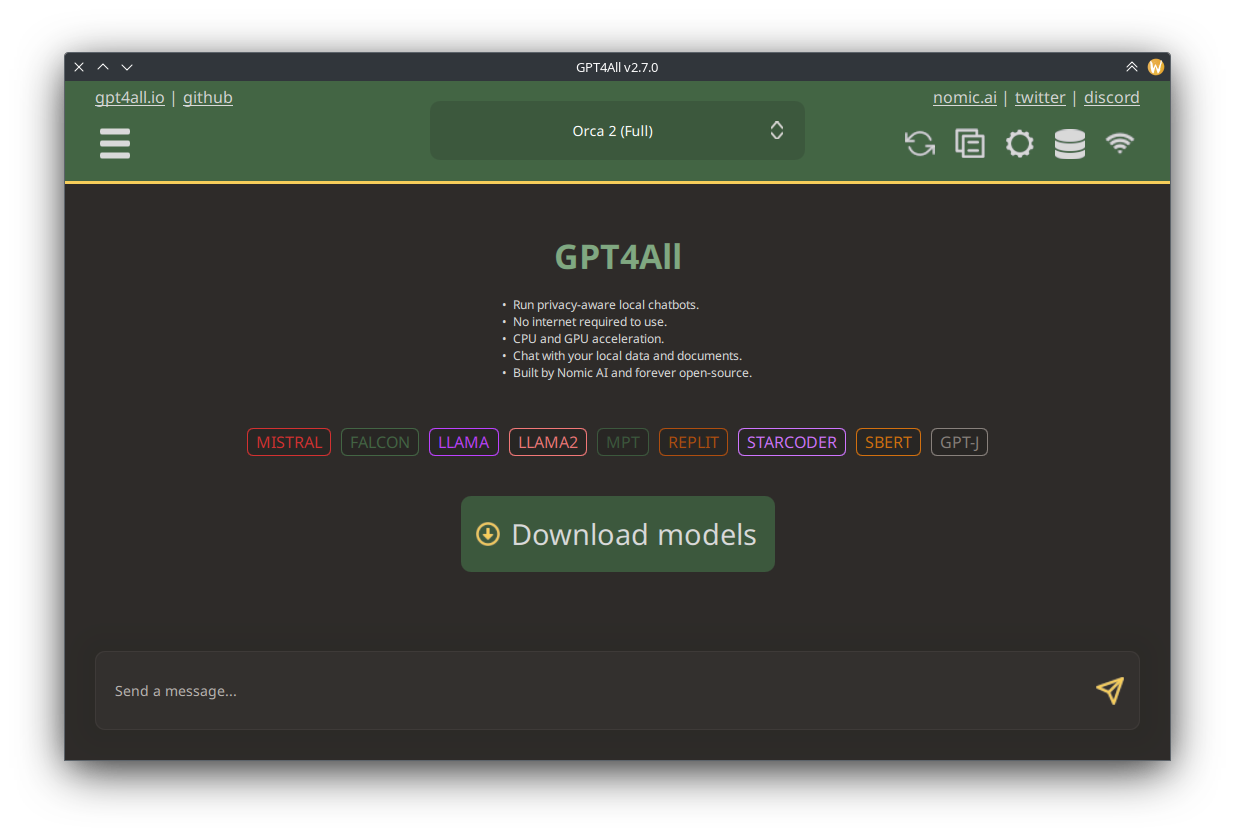

После первой установки в программе не будет ни одной языковой модели, с которой можно будет взаимодействовать. Чтобы их установить, после первого запуска GPT4All жмём на кнопку «Download models».

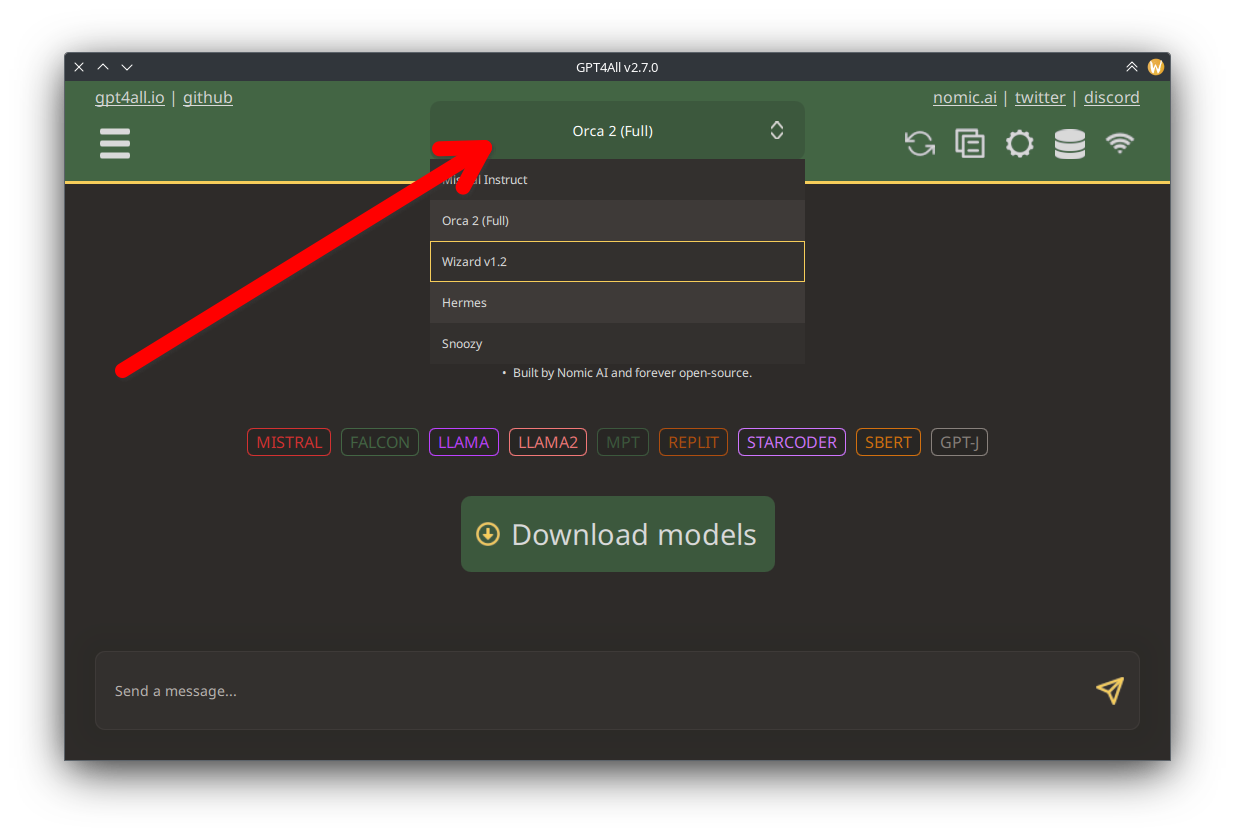

В открывшемся окне напротив интересующей модели нажимаем кнопку «Install» и ждём завершения скачивания. Далее переходим в главное окно, вверху выбираем модель, внизу пишем промт и начинаем общение.

Если модель отвечает на английском, можно попросить её отвечать на русском. Мне понравились Orca 2 (full), Wizard v1.2.

Особенности локально выполняемых языковых моделей

Так как нейросетки в GPT4All выполняются локально, следовательно для возможности их быстрой работы оборудование должно быть соответствующим. При недостатке видеопамяти в видеокарте, нейронка будет работать на CPU и использовать системную ОЗУ. У меня 16 Гб, и занимает её в процессе построения ответа значительно. Думаю, можно попробовать на 8 Гб, но, скорее всего, не все модели заведутся.

Другой особенностью локально выполняемых нейронок является то, что у них отсутствует какое-либо ограничение на выдаваемый контент. В случае с Copilot, например, там работает две нейронки: одна отвечает, а вторая следит за тем что отвечает первая, и в случае нахождения в ответе «нелегального» контента тут же заменяет вывод на заглушку. Ваша же локальная нейронка расскажет вам и как ломать Wi-Fi с помощью aircrack-ng, и как повесить шелл на взломанный Android с помощью Metasploit. Конечно же, вся информация предоставляется исключительно для ознакомления и так далее. В моделях есть некоторая защита от явного adult-контента, но она легко обходится, и вы получаете то, что вам надо 😏

Рекомендую после установки зайти в настройки и выставить верное количество ядер процессора согласно вашей конфигурации железа (опция CPU Threads), которые GPT4All будет использовать в случае работы на CPU вместо GPU.

Продуктивного общения 😎